今回は動画生成AIに関する話題で

オープンソースの動画生成モデル「Wan2.2」の導入方法と使い方

を丁寧に解説するという内容になっております。

動画生成AIというと少し前までは「生成が遅くて品質も悪い」「生成結果に一貫性がない」という感じだったのですが、ここ最近の進歩は凄まじくそれらの弱点を急速に克服しつつあります。中でもアリババが開発した動画生成AIの最新版「Wan2.2」を使うと高品質な動画をローカルで生成できるとのことだったので、遅ればせながら私も試してみました。

ここではこのWan2.2の導入方法や使い方について書いていきますね。

Wan2.2とは?

公式サイト

Wan2.2の概要と特徴

Wan2.2は中国のアリババが開発し、2025年7月末頃にリリースしたオープンソースの動画生成モデルです。主な特徴は次の通り。

- オープンソースモデルなので誰でも無料で利用可能。また、ローカル環境で動かすこともできる

- まるで映画のようなリアルで美麗な映像を生成可能

- 用途に応じた複数のモデルを提供

- 最適化されたモデルはミドルクラスPCでも動く

- 画像生成ツールとしておなじみのComfyUIで動作可能

動画生成に必要なPCスペックについて

次にWan2.2を使ったローカル環境での動画生成に必要なPCスペックについてご説明しておきます。「最低これ以上は必要」というレベルのスペックは下記のとおりです。

- GPU(グラボ):RTX 3060(VRAM 12GBモデル)以上の性能

- メモリ:32GB以上

動画生成においてはグラフィックボードのVRAM容量が非常に重要です。調べた限りだとVRAM8GBでも生成できないこともない…みたいな情報があるようですが、最低12GB・できれば16GBくらいは欲しいところでしょう。

もしグラボのVRAMが足りないな…という方で動画生成に興味がある場合はグラボの買い替えも検討するのがよいのではないかと思います。執筆時点ではGeForce RTX 5060Tiの16GBモデルがコスパがいいのでお勧めです。

Wan2.2で生成したサンプル動画

さて概要についてご説明したところで、実際に私がWan2.2を使って生成したサンプル動画をご覧いただこうと思います。

Wan2.2では「テキストから動画生成」「画像から動画生成」など生成のやり方がいくつか用意されていますが、個人的に画像から動画生成するやり方(=Image to Video、通称i2v)が好きなのでサンプル動画の生成ではその方法を使いました。

サンプル1:スーツを着た熊のプレゼン動画

私が自画像として使っている「スーツを着た黒い熊」がプレゼンを行っている画像を元にして動画を作ってみました。

生成された動画と使用したプロンプトは下記です。

プロンプト:

A black bear in a suit is giving a presentation about a technology blog called "KurokumaSoft" in a clean, white office. When the bear's presentation is over, the camera dollies out to show businessmen applauding the bear.サンプル2:フィギュア風の女の子の動画

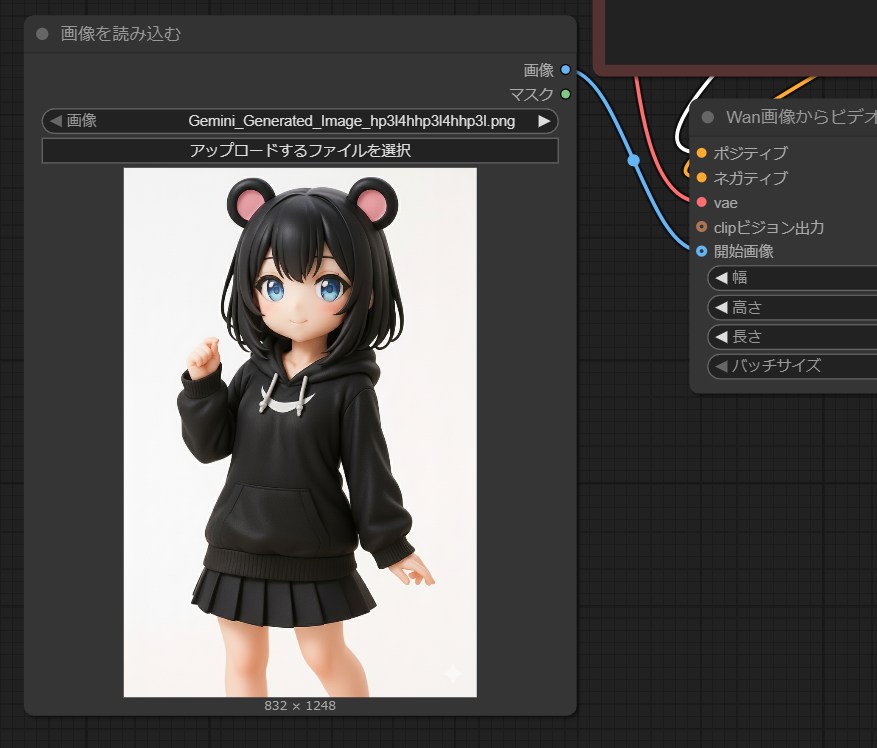

次にGeminiで生成した、私オリジナルのキャラクター「くろくまちゃん」のフィギュア風画像を動画化してみました。元画像は下記のとおり。

生成された動画と使用したプロンプトは下記です。

プロンプト:

An anime-figure-style girl wearing a black hoodie and skirt is taking a selfie with her smartphone while striking a cute pose. She turns to the viewer and waves her hand with a cute smile.ComfyUIを使ったWan2.2の導入方法

ではここからが本題で、Wan2.2の導入方法や使い方を解説していきます。まずはローカルでの動作に必要な環境を整えたり、必要なモデルをダウンロードしたりしましょう。

ComfyUIのインストール

まず、Wan2.2を手軽に動かすためには専用のツールが必要です。既に画像生成や動画生成を行っている皆さんにはお馴染みのComfyUIというツールが最もメジャーで汎用性も高い(=導入しておけば動画だけでなく画像生成もできる)ので、ここではこのツールを使う場合の解説を行います。

ComfyUIの導入方法は別の記事で詳しく解説していますので、まだインストールしてないよという方はまずはComfyUIのインストールを済ませましょう。

必要なモデルのダウンロード

次に必要なモデルをダウンロードしておきます。使用するモデルはWan2.2の公式モデルでもいいのですが、公式モデルよりも低スペックなPCで動く最適化されたモデル(量子化モデル)があるのでここではそれを使うことにします。

今回はサンプル動画の生成に使った画像から動画生成(Image to Video、通称i2v)を行えるモデルを使うものとします。

上記ページにはi2v用の色々な量子化モデルがありますが、とりあえずここでは

- wan2.2_i2v_high_noise_14B_Q4_K_S.gguf

- wan2.2_i2v_low_noise_14B_Q4_K_S.gguf

の2種類をダウンロードしておいてください(Wan2.2ではhigh_noiseというモデルとlow_noiseというモデルの2種類を使います)。

ダウンロードできたらこれらのモデルをComfyUIのユーザーフォルダ内にある下記のフォルダに入れましょう。

models\diffusion_modelsWan2.2用のComfyUIワークフローの導入方法

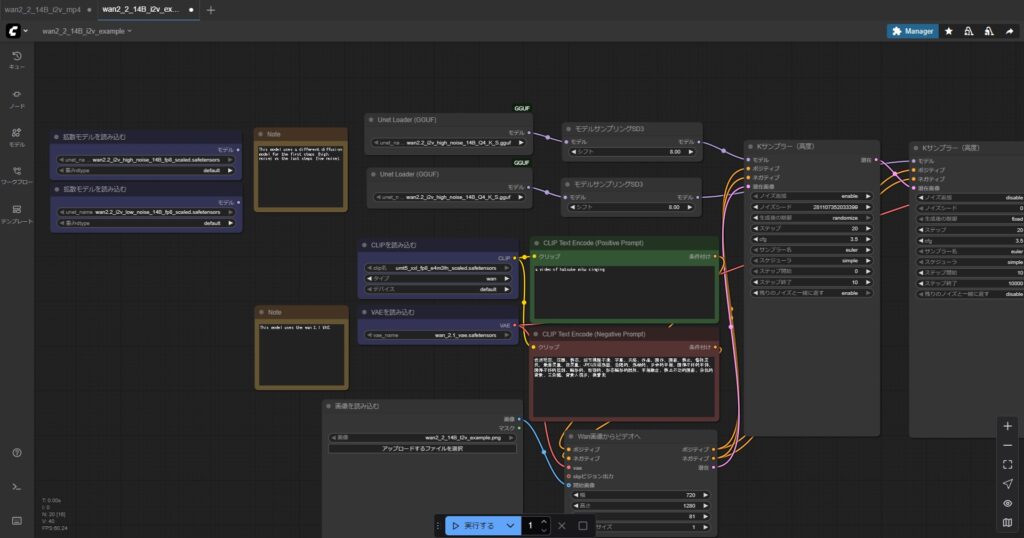

次に、ComfyUIで動画生成を行うためには専用のワークフロー(=処理の流れ)を導入する必要があるのでその解説を行います。また、そのワークフローを使ってどのように動画を生成するのかも解説しますね。

ワークフローの導入方法

wan2.2のi2v用の量子化モデルを使うためのワークフローは先ほどのHugging Faceのページからダウンロードできる画像(リストの一番下にある「wan2_2_14B_i2v_example.png」)に含まれています。

この画像をダウンロードしてComfyUIの画面にドラッグ&ドロップすると自動的にワークフローが読み込まれます。

ただし初めてComfyUIを使う方の場合は「ノードが足りません」的なエラーが出ると思いますので、指示に従って必要なノードのインストールを行ってください。

ワークフローの改造方法(モデル変更・MP4形式で保存)

さてワークフローを読み込んでいただいたのですが、このままだと次のような問題があります。

- 動画生成に使用するモデルが違う

- 保存形式がMP4ではなくWebPになっている

そこでワークフローを改造して使用するモデルを変更し、MP4形式で保存するようにしてみましょう。

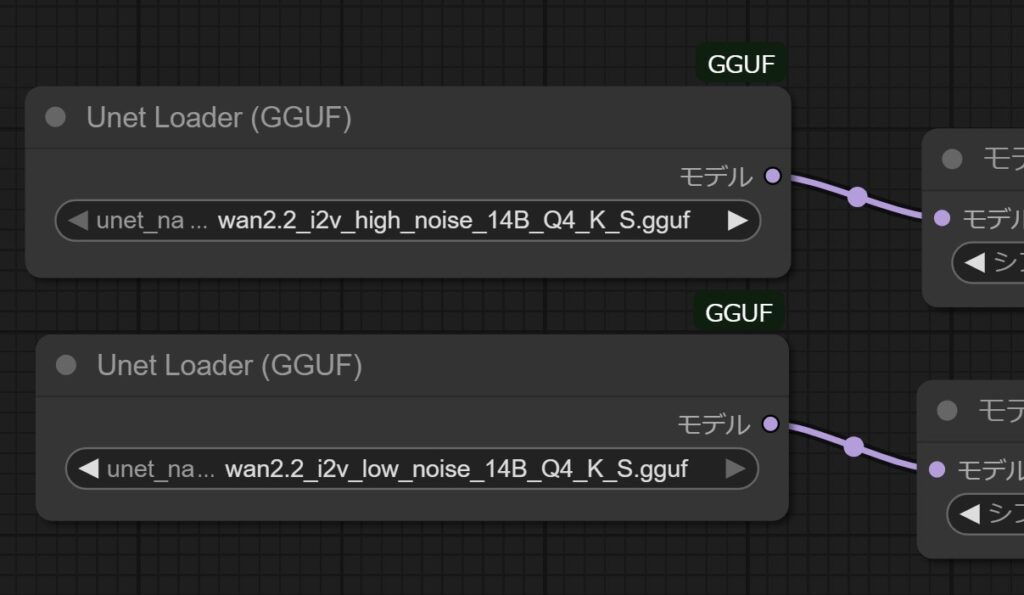

モデル変更

まずモデルの変更はUnet Loader(GGUF)ノードで指定されているモデルを変更します。モデル名が入っている部分の三角マークを押すとモデルが切り替わると思うので、下記の画像の通りに設定しましょう。

- 上側:high_noiseを指定

- 下側:low_noiseを指定

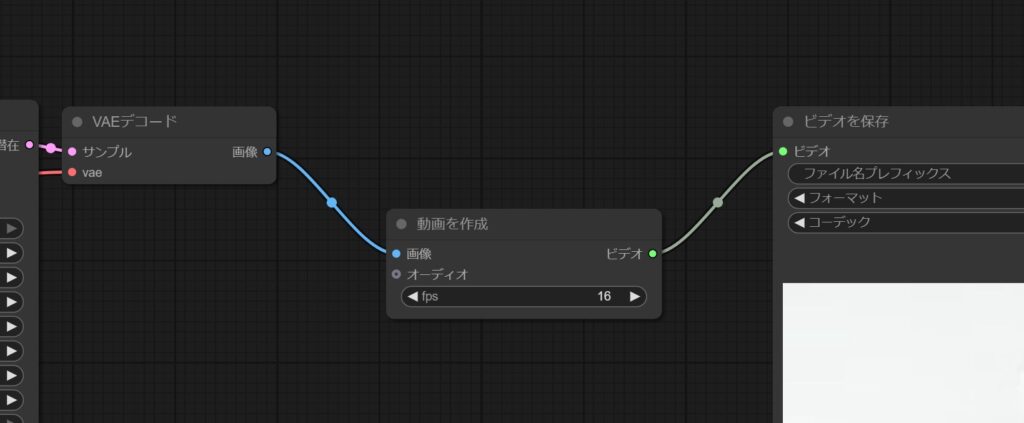

MP4形式での保存

次に、動画をMP4形式で保存するようにするためにはVAEデコードノードから先を下記のように変更します(VAEデコード→動画を作成→ビデオを保存 という風にノードをつなぐ)。

ノードを追加するには、画面の何もないところで右クリック→「ノードを追加」を選択します。ビデオ関係のノードは下記の位置にあります。

画像→ビデオあとは「ビデオを保存」ノードの「フォーマット」をmp4にすればOKです。

動画生成のやり方

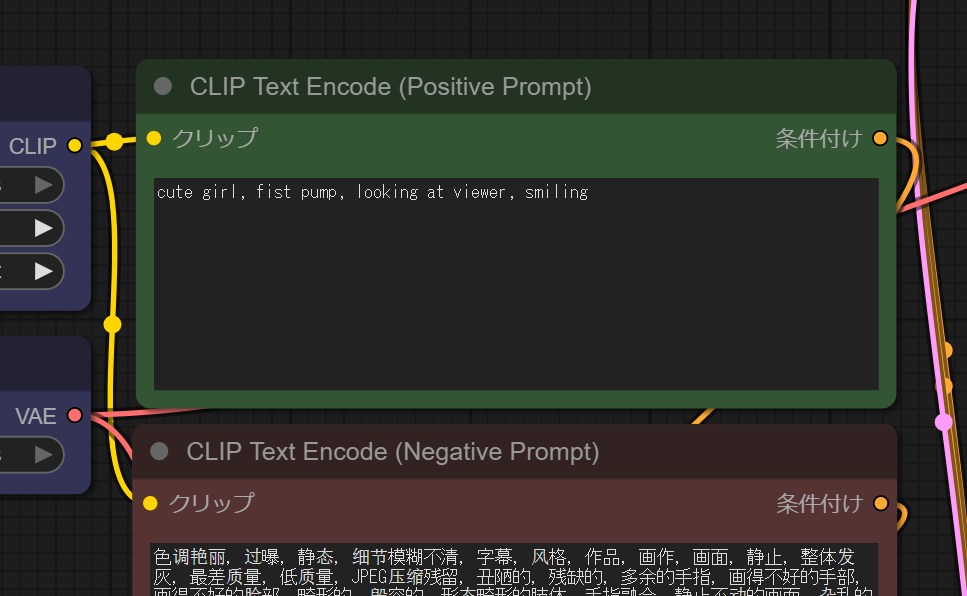

さて、ここまでの作業で準備ができたのでようやく動画を生成できます。今回はi2vを行うということで適当な元画像を用意し、プロンプトを記入してワークフローを実行すれば動画生成が可能です。

まず、元画像は「画像を読み込む」ノードからアップロードできます。

次にプロンプトは緑色の「CLIP Text Encode (Positive Prompt)」ノードに記入しましょう。

あとは画面下の青い「実行する」ボタンを押せば生成開始です!しばらく待つと動画が生成されて「ビデオを保存」ノードでプレビューできるようになります。

なお生成された動画はComfyUIのユーザーフォルダ内の下記フォルダに入っているので確認してください。

output\videoおまけ:動画生成処理の高速化

最後におまけとして動画生成処理の高速化方法をご紹介しておきます。先ほどのワークフローのままだと数秒の動画を生成するのに何分もかかったりするので高速化しておくと便利です。

まず、高速化のためには必要なモデルをダウンロードします。下記ページに「lightx2v_I2V_14B_480p_cfg_step_distill_rank32_bf16.safetensors」というモデルがあるのでそれをダウンロードし…

ComfyUIの下記フォルダに入れてください。

models\loras次にワークフローを改造します。「LoRAローダー モデルのみ」というノードを作って先ほどのモデルを指定し、下記のように接続しましょう。

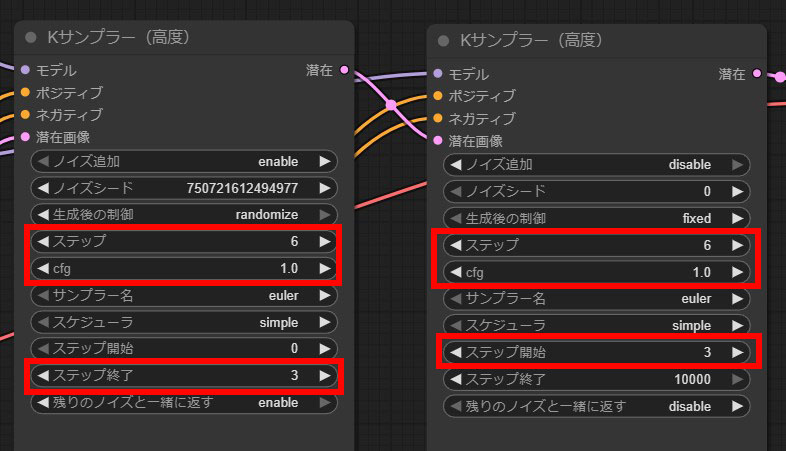

そうしたら最後に「Kサンプラー」の設定を下記のように変更します。

- ステップ数を6くらい、cfgを1.0に変更

- 左側のKサンプラー:ステップ終了を3に変更

- 右側のKサンプラー:ステップ開始を3に変更

これで動画生成処理が相当速くなるはずです!

おわりに

以上、Wan2.2の導入方法や使い方を一通りご紹介しました。Wan2.2はミドルスペックPCでも動かすことができて高品質な動画を生成できるモデルなので、ぜひ皆さんも試してみてください。

この記事が動画生成のお役に立てば幸いです。