今回もStable Diffusion web UIの拡張機能に関する話題で、タイトルの通り

をご紹介するという内容になっています。

最近は画像生成AIが急速な進歩を遂げているわけですが、今度は動画を自動生成できる技術が登場して海外の掲示板「reddit」等で注目を集めています。しかもいつも通り速攻でStable Diffusion web UIから動画生成を行える拡張機能「text2video Extension」が登場したので、私も実際に試してみました。

ここではこの拡張機能について

- 概要・具体的にどんな動画を生成できるのか

- Stable Diffusion web UIへのインストール方法

- 基本的な使い方

を丁寧にご説明していきますね。

アップデートで新機能の追加や機能改善・拡張機能の名称変更などがあったので記事の内容を更新しました。

「text2video Extension」の概要

公式ページ

text2video Extensionとは?

「text2video Extension for AUTOMATIC1111’s StableDiffusion WebUI」(※長いので以下略称を使います)はStable Diffusion web UI用の拡張機能で、小さくて短い動画を自動生成することができます。執筆時点ではまだ登場したばかりで低解像度・低精度の動画しか生成できませんが、この拡張機能の登場でいよいよ一般人でも手軽に動画を自動生成できる時代に突入した感があってとてもワクワクします。

なおStable Diffusion web UIをまだインストールしていないよ、という方は下記の記事でインストール方法や使い方などを丁寧に解説しているので、そちらも併せてご覧ください。

実際に生成した動画のサンプル

さて百聞は一見に如かず…ということで、実際に私が生成した動画のサンプルを掲載しておきます。

クマが大量の砂金(?)の上を歩いている短い動画が生成されました。執筆時点では生成される動画は内容・画質共にクオリティがまだまだ低いのですが、画像生成AIの進歩を見ていると動画も近々ハイクオリティなものが作れるようになると思います。その辺は期待大ですね。

アップデートによってもう少し長い動画も作れるようになりました。12GBのVRAMがあれば125フレームまでの動画を作れるようです。

Stable Diffusion web UIへのインストール方法

text2video Extensionをweb UIにインストールするには次の2つの作業が必要です。

- 拡張機能リストからtext2videoをインストールする

- 動作に必要なモデルをダウンロードして所定のフォルダに入れる

拡張機能リストからtext2videoをインストールする

まずは他の多くの拡張機能と同様に、web UIの拡張機能リストからインストールを行います。web UIの拡張機能タブ→「拡張機能リスト」→「読込」ボタンを押すと、一覧にtext2video Extensionが出てくるので「インストール」ボタンを押しましょう(※もちろん無料です)。

インストールできたらweb UIを再読込してください。

動作に必要なモデルをダウンロードして所定のフォルダに入れる

次に、動作に必要なモデル等をダウンロードして所定のフォルダに入れます。この拡張機能は現時点では

- ModelScope

- VideoCrafter

の2つのモデルに対応しているので、それぞれ必要なファイルを用意しておきましょう。

ModelScope

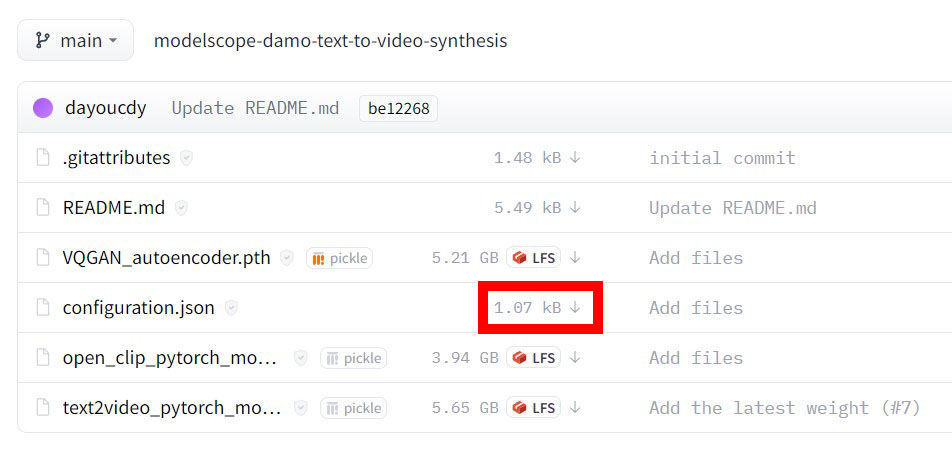

必要なファイルは次の4つです。

ファイルは下記ページからダウンロードできます。

また、グラフィックボードのVRAM容量が6GB以下の場合は下記ページに軽量版モデルがあるのでそちらを使ってください。

ダウンロードできたらこれを下記フォルダに移動させましょう(※「ModelScope」フォルダ以下がない場合は自分で作る必要があります)。

VideoCrafter

下記ページからモデル(model.ckpt)をダウンロードして所定のフォルダに入れます。フォルダがない場合は自分で作ってください。

text2video Extensionの使い方

ではここからtext2video Extensionの使い方についてご説明していきます。

text2videoタブ

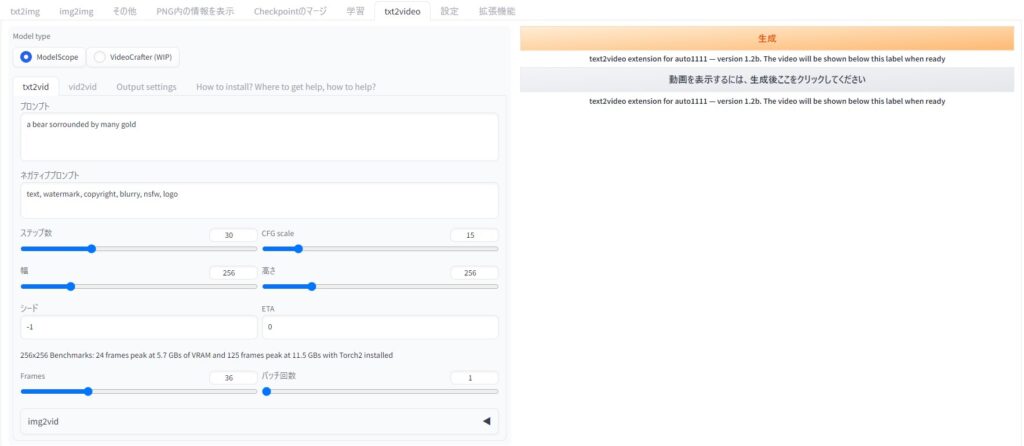

拡張機能が正常にインストールされると、「text2video」タブが表示されるのでそれを選択しましょう。すると下のような設定画面が出てきます。

主な設定項目は次のとおりです。

- Model Type:

Modelscope・VideoCrafterのどちらを使うかを選択します。 - プロンプト・ネガティブプロンプト:

画像生成のときと同様にプロンプトを指定します。ただし、執筆時点では複雑なプロンプトは指定できないようなので簡潔に書きましょう。 - frames:

動画のフレーム数(=動画を構成する静止画の枚数)。この値と、後述するフレームレートの設定によって動画の長さが決まります。 - 幅・高さ:

動画の解像度。グラフィックボードのVRAMが少ない場合は小さめに設定しておいた方がよいでしょう。

Output Settingsタブ

txt2videoタブを設定したら、次はOutput Settingsタブを開いて設定を行いましょう。いくつか設定項目がありますが、とりあえず「フレームレート」だけは決めておいてください。

動画の長さは下記の計算式で決まります。

例えばフレーム数=24・フレームレート=8のときは動画の長さは3秒になります。執筆時点ではフレーム数はそこまで多くできないので、動画の尺を少しでも長くしたい場合は、フレームレートを落とせば滑らかさと引き換えに動画の時間を長くすることができます。

動画の生成・出力先について

設定が済んだらオレンジ色の「生成」ボタンを押すと動画の生成が始まります。ボタンを押してもweb UIの画面には何も出ないので、web UIのコンソールのほうで処理の進捗を確認してください。グラボの性能や動画の解像度・長さにもよりますが時間はそれほどかかりません。

生成が終わると「Update the Video」で動画を確認することができます。また、生成した動画の出力先は下記のとおりです。

このフォルダ以下にサブフォルダが作られて、連番の静止画(PNGファイル)と動画ファイル(MP4)が出力されます。

おわりに

以上、動画を生成できる拡張機能「text2video Extension」の使い方をご紹介しました。いよいよAIで動画まで手軽に自動生成できる時代になりつつあり、これからの発展がとても楽しみです。今後のアップデートにも期待したいですね。

この記事が何かしら参考になれば幸いです。