今回は生成AIを動かすためのツールに関する話題で

対話型AIをローカル環境で手軽に動かせる「LM Studio」の使い方

を丁寧にわかりやすく解説するという内容になっております。

最近は高性能な大規模言語モデル(LLM)が無料で公開されることも多く、「試しに自分のPC(=ローカル環境)で動かしてみたいな」とお考えの方も多いかと思います。しかしLLMはそれ単体では動作しないため、ローカルで動かすためには自分で環境構築を行う必要がありハードルが高いと思っている方も多いのではないでしょうか?

そこでお勧めしたいのがLLMをローカルで簡単に動かせるツールです。そのようなツールは現在はいろいろな種類のものが出回っており、有志の方が無料で公開しているものもあります。私は複数のツールを使い分けているのですが、中でも対話型AIを動かすのに便利な無料ツールとして「LM Studio」が一番手触りがいいのでご紹介しておこうと思いました。

このような次第でここではLM Studioのインストール方法や使い方をご説明していきますね。

LM Studioとは?

公式サイト

LM Studioについて

LM Studioは大規模言語モデル(LLM)をローカル環境で手軽に動かせる無料ツールです。最新のLLMに幅広く対応している点や直感的でわかりやすいデザインが特徴で、これを使えば初心者の方でも簡単にLLMを動かして遊ぶことができます。

前提知識:LLMをローカルで動かすことのメリット(&デメリット)は?

メリット

さてLM Studioの概要はこんなところですが、そもそもの話「オンラインで高性能な対話型AIを手軽に使えるのになんでわざわざローカルでAIを動かす必要があるんだろう?」と思った方もいらっしゃるかと思います。この点については下記のような明確なメリットがあるためです。

まずオンラインの対話型AIはユーザーの入力を保存したり学習に使用したりするため、個人情報や機密情報は絶対に入力してはいけません。しかしローカルAIであればユーザーの入力は他人と共有されることはなくより安全性が高いと言えます。

また、オンラインの対話型AIでは例えばHな会話をするとアカウントが停止されてしまうことがあります。しかしローカルAIの場合はそのようなことはありませんし、会話が外部に漏れるといったこともないので他人に知られたり怒られたりしたくないような使い方をしたい場合はローカルのほうが便利です。ただし、モデルによっては例えば公序良俗に反する使用や反社会的な使用に対して応答しないようにできているものが多いため、ローカルだからHな会話ができるとは限らない点は注意が必要です。

デメリット

一方でローカルでLLMを動かすためには高価なPCパーツが必要だったり、ローカルで使えるLLMは性能が少し悪かったりといったデメリットもあります。もう少し具体的に言うと

といった感じです。この点も考慮してローカルLLMを楽しみましょう。

LM Studioのインストール方法

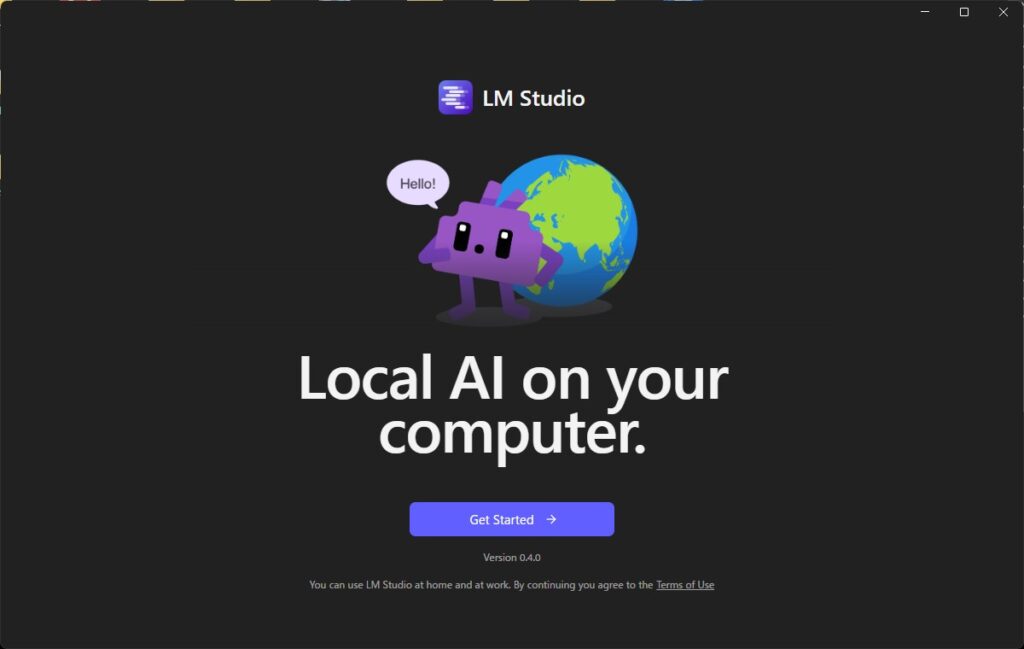

ではこの辺でさっそくLM Studioをインストールしてみましょう。インストール方法は簡単で、公式サイトからインストーラーをダウンロードして実行するだけです。

インストールが完了したらLM Studioを起動してみましょう。すると下記のような画面になるので、「Get Started」を押します。

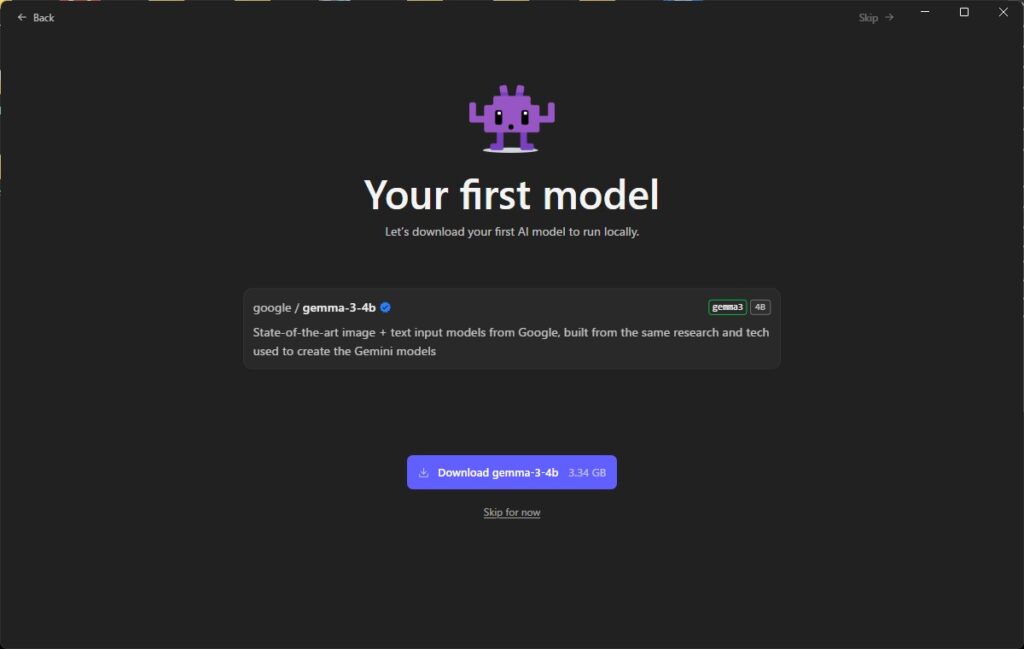

次の画面ではGoogleの「Gemma」というモデルを最初のモデルとしてダウンロードするかどうか聞かれます。

LM StudioはAIを動かすためのツールですが、まだAIモデルを導入していないのでそのままでは動かすためのAIがない状態です。なので「自分でモデルを用意していないけど、とりあえずサクッと試してみたい」という場合はダウンロードボタンを押しましょう。

ダウンロードボタンを押した後の「Continue」ボタンを押すか、スキップすると次の画面になります(※ダウンロード中でも次に進めます)。高度な設定が表示されますが、特に理由がなければそのまま「Continue」ボタンを押しましょう。

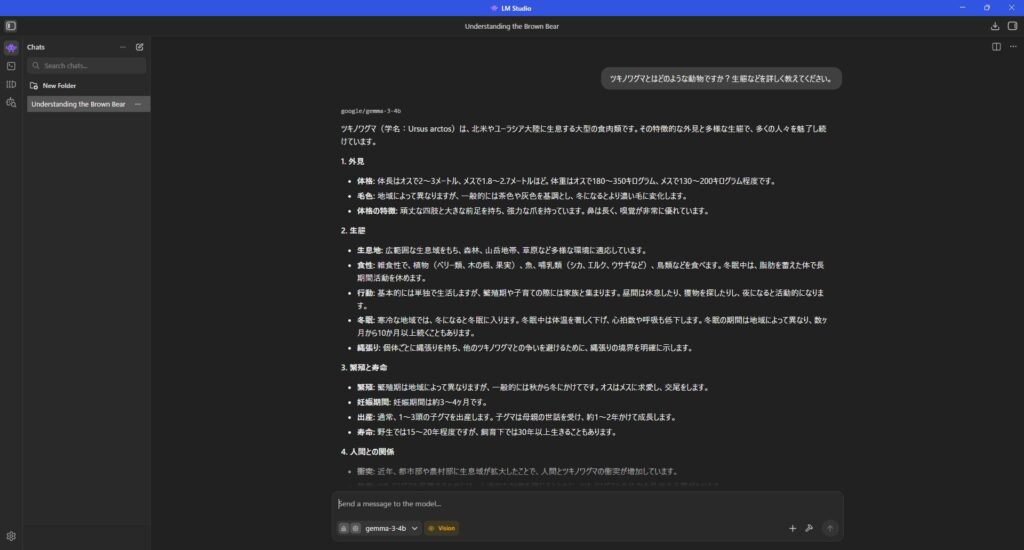

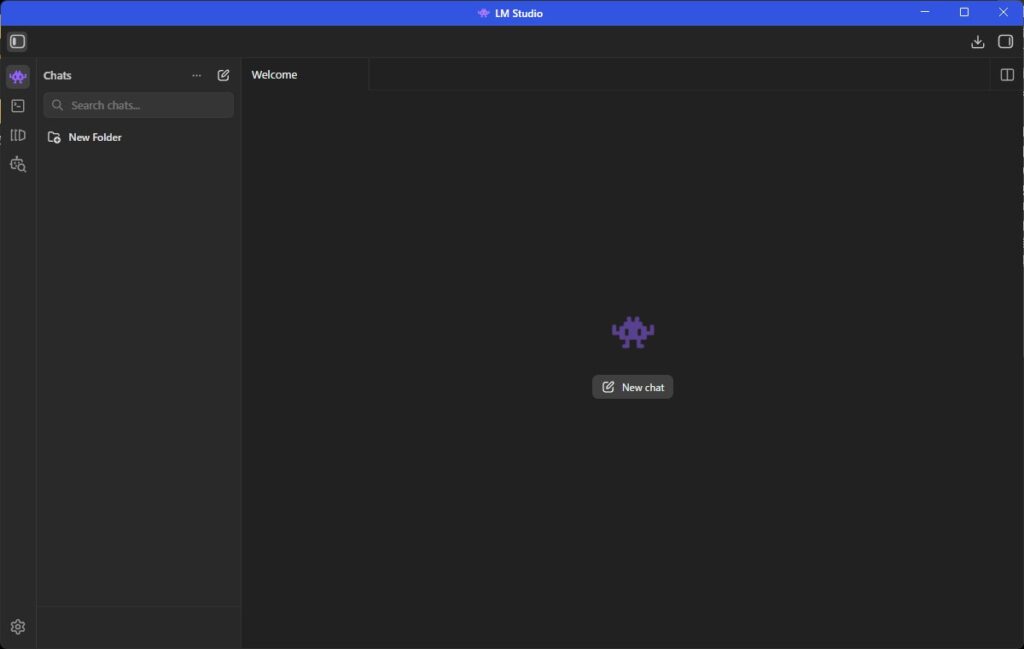

これでセットアップ完了です!「Continue to LM Studio」ボタンを押すと下記のような画面になります。

LM Studioの使い方

ではここからが本題で、LM Studioの使い方を一通り解説していきます。

ローカルLLMとのチャットの始め方

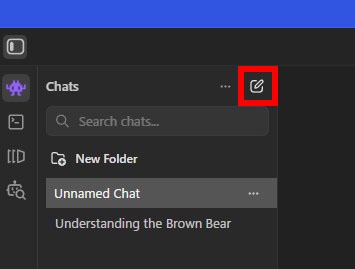

新しいチャットの作成方法

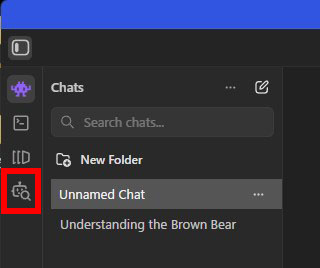

新しいチャットを始めるにはサイドバー右上のアイコンをクリックします。

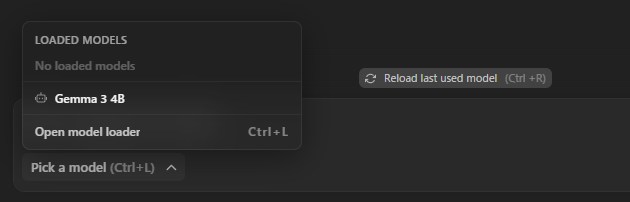

モデルのロード&チャットのやり方

次に、最初はモデルが何も読み込まれていない状態なので予め用意したモデルをロードする必要があります。チャットの入力欄の「Pick a model」をクリックするとモデル一覧が表示されるので好きなモデルを選びましょう。もしインストールの手順でGemmaを導入済みの場合はそれが表示されるはずです。

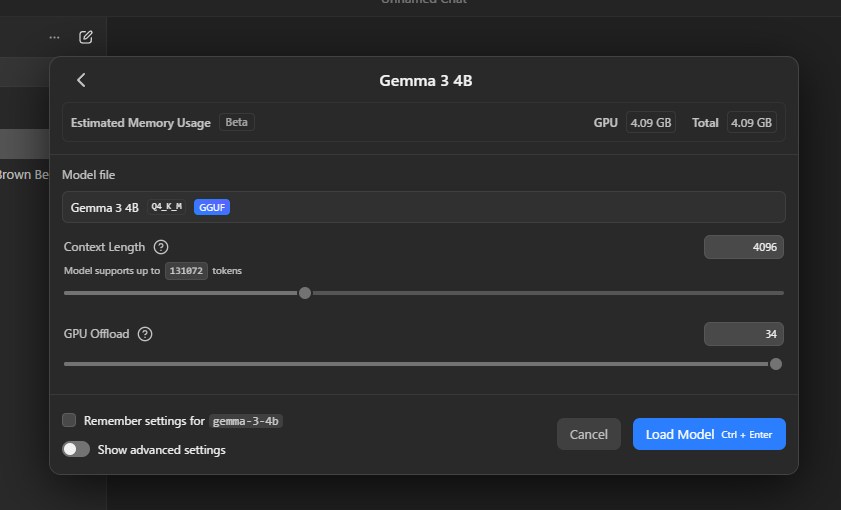

すると選んだモデルの設定ウィンドウが出るので、特に理由がなければデフォルトのまま「Load Model」ボタンを押せばOKです。しばらく待つとモデルが読み込まれてチャットできるようになります。

あとはChatGPTなどとほぼ同じ要領でLLMとやり取りすることができます。なおモデルによっては画像などのファイルをアップロードして読み取ってもらうといったことも可能です。

別のモデルの導入方法

さて、しばらくチャットで遊んでいると別のLLMを試したくなってくることでしょう。特にデフォルトの「Gemma 3 4B」は非常に高速ですが性能はあまり良くないので、もっと性能がいいモデルを使ってみたくなる方は多いと思います。

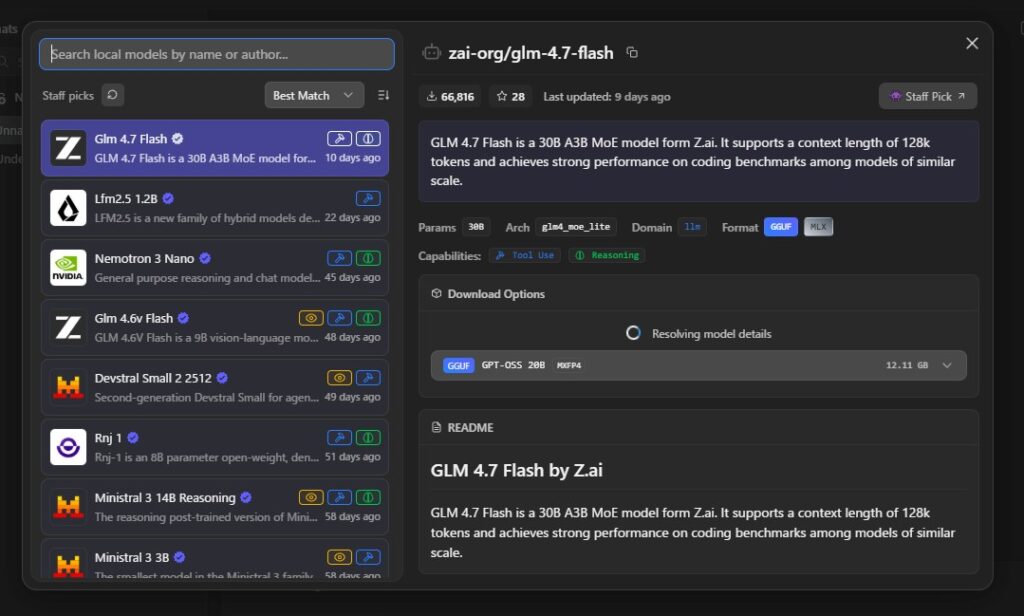

そのような場合もLM Studioなら簡単に新しいモデルを導入できます。やり方は、まずサイドバーのロボットアイコン(Model Search)をクリックし…

好きなモデルを選んでダウンロードするだけです。

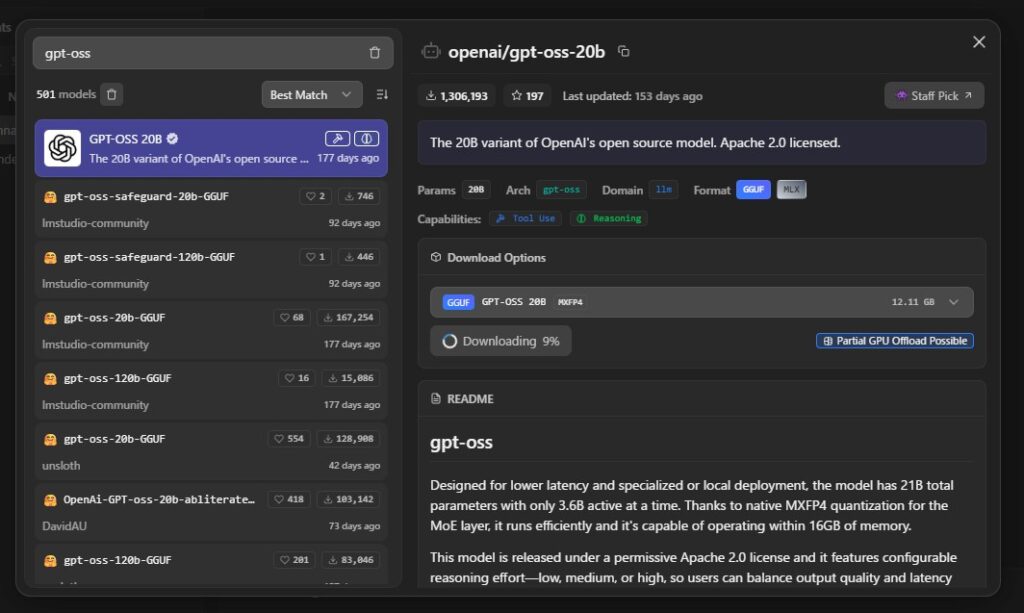

例えばOpenAIが提供している無料LLMの「gpt-oss」を使う場合は、検索欄に「gpt-oss」と入力して出てきたモデルをダウンロードします(※検索結果には非公式なモデルも表示されます)。

カスタム指示(Custom Instructions)の記入方法

最後に、LLMにカスタム指示を与える方法をご紹介しておきます。これを使えば「こういう風に返答してほしい」といったことを予め指定することが可能です。

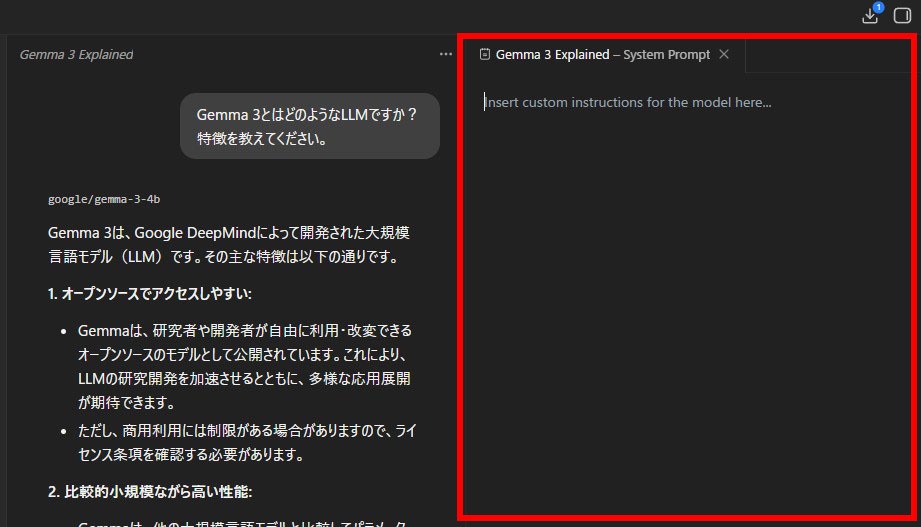

やり方は「Ctrl+E」を押すか、画面右上の「…」ボタン→「Add instructions」を選択すると下記のような画面が出るので、そこに任意の指示を記入するだけです。

おわりに

以上、LLMをローカルで簡単に動かせるLM Studioの導入方法や使い方について解説しました。LM Studioは本当に手軽に対話型AIを動かせるのでローカルAI初心者の方にもおすすめです。ぜひ皆さんもこの機会に試してみてください。

この記事が何かしらお役に立てば幸いです。